3月21日星期二下午,经济学院校友系列讲座第二十讲“从词向量到ChatGPT——如何让计算机理解人类语言”在上海财经大学武川路校区高等研究院502报告厅举行,本次活动特邀复旦大学博士、KPMG金融科技专家库成员-冯剑校友来校与同学们进行了面对面的交流,讲座现场,同学们通过冯老师的分享和同学们与老师的交流互动,充分了解了计算机是如何理解人类语言背后的逻辑,并重点讲述了自然语言处理(NLP)的主流发展路径,冯剑校友用举例和类比的方法,为经院学子提供一场通俗易懂的算法入门讲座。学院校友会负责人黄振兴常任教授、工会主席黄枫副研究员、校友会干事胡倩楠老师以及经济学院2006级戴聪聪校友参加讲座。

首先,冯剑校友介绍了计算机理解人类语言的起点——词向量,并从归纳与分类的表格化、词向量的简单计算、词向量的优化三个方面来介绍。

词向量是计算机把文字转化为数值的两种方式之一,具有信息密度高,逻辑关系可推导的优点,但是它计算量大、不直观、不易理解,NLP算法便采用的是词向量的方式。人类可以通过归纳与分类来理解事物,并且可以把归纳与分类的词向量表格化,如猫、狗、玫瑰花是可以通过物种类别、触感、气味、声音、温度等来分类的!

计算机赋予每个词向量一定的数值,便可以进行词向量之间的相关性计算,即向量化的意义是可计算的,思考题:“国王-男+女 = ?”

词向量的优化。如果两个词向量的相关性较强,我们可以把它视为一个词向量,并进行列的压缩,减少储存空间、尽可能增加词向量的区分度!其中Bert模型有768维,GPT模型有12288维。

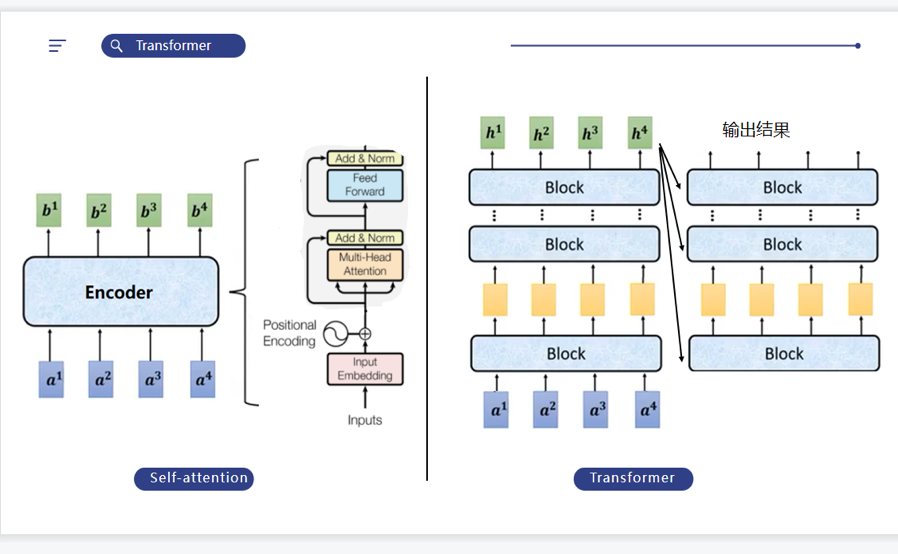

然后,冯剑校友为我们阐述了优质模型的内核——Transformer,分别从NPL的两种算法、注意力机制、Transformer的结构简介三方面入手。

接着,冯剑校友又为我们讲解了两大主流模型:Bert和GPT。基于以上观点,他最后提出了对ChatGPT的未来猜想:标准化,今后具有完备功能的大模型将会取代各种小模型;对话机制:未来的计算机语言将会转化为人类语言;新职业诞生:提示词工程师、对话工程师将会成为未来的新兴热门职业。

现场提问环节,现场老师同学们针对ChatGPT处理语音、图片的可行性问题、人工智能时代AI发展对于人类冲击的思考以及在校学生的知识储备等感兴趣的问题踊跃提问,冯剑校友分别给予耐心解答。通过本次讲座,现场同学们对NLP的主流发展路径有了更深的认识,相信大家都收获满满,为今后在信息化时代发展做足准备!

黄枫副研究员还为冯剑校友颁发了“匡时论坛——上财经济学院校友会系列讲座”荣誉讲师。

此外,本次活动也是上海财经大学分团委学生第二课堂的常规讲座,未来经济学院校友会也将陆续邀请更多的校友带来行业经验以及人生经验的分享,帮助同学们从校友的经历中汲取成长经验,更好地规划自己的大学生活,提前探索职业生涯,找到自己的人生奋斗目标。

(供稿:李星雨;供图:张梓童、胡倩楠;编审:黄振兴)